改进基于LLM的异常检测和反应规划的两阶段框架

发布时间:2024-08-16 15:59:04 编辑:闻人菊罡 来源:

大型语言模型(LLM),例如OpenAI的ChatGPT,在回答各种用户查询方面非常有效,并且在许多自然语言处理(NLP)任务中具有良好的泛化能力。最近,一些研究也在探索这些模型在检测和缓解机器人系统故障方面的潜力。

斯坦福大学和NVIDIA的研究人员最近推出了一个新的两阶段框架,该框架可以促进使用LLM检测系统异常并实时规划机器人动作。

这种方法是在一篇获得“机器人:科学与系统”会议(RSS2024)杰出论文奖的论文中提出的,它可以显著提高各种机器人系统(包括自动驾驶汽车)的可信度。这项研究成果可在arXiv预印本服务器上找到。

论文共同作者罗汉·辛哈(RohanSinha)告诉TechXplore:“这项工作始于我们在现实世界中遇到自动驾驶汽车故障模式的例子,例如自动驾驶汽车被卡车运输的一组交通信号灯弄糊涂的情况,或者自动驾驶汽车在高速公路上停下来,因为它驶过了一个带有停车标志的广告牌。”

“这样的例子通常被称为分布外(OOD)输入,这些罕见的极端情况与AV训练的数据有很大不同。”

作为他们之前研究的一部分,Sinha和他的同事发现了仍然阻碍自动驾驶汽车性能的OOD故障。然后他们开始研究现有的OOD检测方法能够在多大程度上发现这些故障。

“例如,现有的跟踪视觉新颖性的方法在检测这些特殊情况时表现不佳,因为与训练数据相比,看到停车标志、广告牌或类似物体在视觉上并不新颖,只有当这些物体出现在广告牌上时,它们才会变得异常,”辛哈说。

“此外,我们发现这些类型的故障模式不容易归因于特定组件(例如感知系统)故障,而是反映了情境推理中的系统级缺陷。这使得它们很难通过现有的组件级监控技术捕捉到。”

在2023年的一篇论文中,研究人员展示了LLM检测和理解这些“语义异常”的潜力。然而,为了有效地使用这些模型来避免影响自主机器人的OOD故障,他们首先必须克服两个关键的研究挑战。

“首先,我们必须降低LLM的计算成本以实现实时反应——最好的LLM非常大,这使得它们运行速度非常慢,这对于快速移动的机器人来说不是很实用,”Sinha说。

“其次,我们需要将基于LLM的推理器集成到动态和敏捷机器人的控制中。我们最近的论文的目标是解决这两个关键挑战,从而证明LLM可以显著提高自主机器人的安全性。”

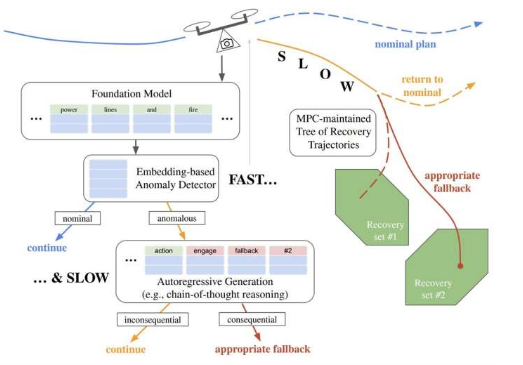

与其他计算模型相比,LLM处理信息的速度可能较慢。主要原因是,为了创建新文本,它们会自回归地单独生成标记。为了生成一个思路链式的文本来推理机器人应该做什么(即规划机器人的动作),LLM所依赖的Transformer模型需要逐个预测数百甚至数千个标记。

使用AESOP算法的四旋翼飞行器的闭环轨迹。来源:arXiv(2024)。DOI:10.48550/arxiv.2407.08735

Sinha解释说:“为了克服这一限制,我们提出了一个两阶段推理流程,其中第一(快速)阶段利用中间输出,即通过变压器模型的单次前向传递产生的单次嵌入,以实现低延迟反应性。”

“在第二(缓慢)阶段,我们仍然依赖最大模型的完整生成思维链能力,对以前从未在数据中记录过的OOD场景做出零样本决策。”

Sinha和他的同事首先使用离线基础LLM模型和现有的名义经验数据集创建了一个语义嵌入向量数据库。在运行时,该团队的框架会嵌入机器人当前正在观察的内容,并计算观察的嵌入与嵌入数据集中包含的嵌入的相似性。这是他们模型的第一阶段(即快速阶段)。

“如果观察结果与之前的观察结果相似,我们将继续执行基本自主堆栈做出的决策,”Sinha说道。“如果观察结果异常,我们会查询一个大型模型来推理采取什么安全保护干预措施(第2阶段:缓慢)。我们将这个2阶段推理框架与一个模型预测控制(MPC)框架配对,该框架计划多次后退并考虑慢速推理器的延迟。”

通过这两个步骤,该框架允许机器人快速检测到异常并减慢其动作,以便LLM模型可以推断出可以采取哪些措施来减轻故障。然后机器人执行LLM提出的自适应计划。

Sinha和他的同事在一系列测试中评估了他们提出的框架,发现它可以增强自主机器人系统中的异常检测和反应规划。值得注意的是,他们的方法被发现优于其他仅依赖LLM生成推理的方法。

“有趣的是,我们发现较小的模型(例如具有110M个参数的MPNet)在异常检测方面的表现与较大的模型(例如Mistral7B)一样好,”Sinha说。“基于嵌入的异常检测器非常擅长检测观察结果与先前经验的不同之处,而使用大型模型进行零样本思维链推理对于确定OOD场景的安全关键性和适当的后备措施确实很有必要。”

总体而言,该研究团队最近的研究表明,快速和慢速推理的部署可以提高使用LLM进行异常检测和机器人规划任务的性能和实用性。未来,他们的框架可以促进使用LLM来增强机器人的稳健性,从而可能有助于改进各种自主机器人系统。

Sinha补充道:“我们的快速推理器实时运行,速度比查询GPT-4快360倍左右,而使用GPT-4进行慢速推理在确定我们评估中细微异常的安全风险方面实现了最高准确率。”

“我们现在计划继续构建这个框架。例如,我们计划使用基于生成推理器的延迟异常评估的持续学习,以避免在非安全关键异常上第二次触发慢速推理器。”

下一篇:新进展利用有机废物生产生物燃料