计算方案加速机器学习同时提升传统数据运算的能效

发布时间:2024-09-29 11:13:57 编辑:阙俊婷 来源:

ChatGPT等人工智能模型依靠算法运行,对数据有着极大的需求,它们通过机器学习来处理数据,但它们的数据处理能力究竟有多大呢?北京大学集成电路学院和人工智能研究所孙忠教授带领的研究人员着手解决限制数据处理的冯·诺依曼瓶颈问题。

该团队在2024年9月12日发表在Device杂志上的论文中,开发了双IMC(内存计算)方案,不仅加速了机器学习的过程,还提高了传统数据运算的能源效率。

在制定算法时,软件工程师和计算机科学家依赖于称为矩阵向量乘法(MVM)的数据操作,该操作支持神经网络。神经网络是一种计算架构,常见于模仿人类大脑功能和结构的AI模型中。

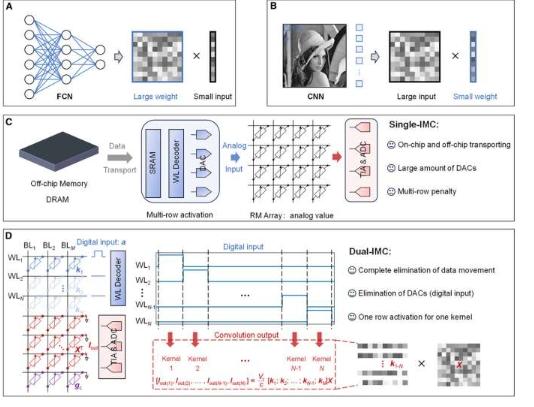

随着数据集规模的快速增长,计算性能常常受到数据移动以及处理和传输数据的速度不匹配的限制。这就是所谓的冯·诺依曼瓶颈。传统的解决方案是单内存计算(single-IMC)方案,其中神经网络权重存储在内存中,而输入(例如图像)由外部提供。

然而,单IMC的缺点是片上和片外数据传输之间的切换,以及数模转换器(DAC)的使用,这会导致较大的电路占用空间和高功耗。

双内存计算可实现完全内存中的MVM操作。来源:Device(2024)。DOI:10.1016/j.device.2024.100546

为了充分发挥IMC原理的潜力,团队开发了一种双IMC方案,将神经网络的权重和输入都存储在内存阵列中,从而以完全内存的方式执行数据操作。

随后,该团队在电阻式随机存取存储器(RRAM)设备上测试了双IMC,以进行信号恢复和图像处理。以下是双IMC方案应用于MVM操作时的一些好处:

由于完全内存计算,实现了更高的效率,从而节省了片外动态随机存取存储器(DRAM)和片上静态随机存取存储器(SRAM)所需的时间和能源

通过完全内存的方式消除了数据移动这一限制因素,从而优化了计算性能。

由于消除了单IMC方案中所需的DAC,生产成本降低。这也意味着节省了面积、计算延迟和功率要求。

在当今数字时代对数据处理的需求快速增长的情况下,该研究的发现可能会带来计算架构和人工智能的新突破。

上一篇:无氟电池保护环境并提高性能